Accueil >> Gestion des risques >> Types de risques >>

🤖 Risques liés à l’intelligence artificielle (IA) : enjeux et conformité

💡 Ce qu’il faut retenir

L’intelligence artificielle transforme profondément les organisations en offrant des leviers puissants d’automatisation, d’aide à la décision et d’innovation.

Mais son déploiement soulève aussi de nouveaux risques techniques, éthiques, juridiques et organisationnels qu’il est nécessaire d’anticiper.

Les risques IA concernent l’ensemble des situations où les systèmes automatisés peuvent produire des effets indésirables, biaisés ou contraires à la réglementation.

Comprendre les risques IA

Les risques associés à l’IA émergent à toutes les étapes du cycle de vie d’un système : conception, entraînement, déploiement et utilisation.

Ils touchent à la fois :

- La qualité et la représentativité des données utilisées ;

- La transparence et la traçabilité des algorithmes ;

- Le respect des droits fondamentaux et de la vie privée ;

- La responsabilité en cas de dysfonctionnement ou de décision erronée.

L’enjeu est de garantir un usage fiable, explicable et éthique des technologies d’IA.

🧩 Typologie des risques IA

A. Risques techniques

- Biais dans les données d’apprentissage ;

- Opacité des modèles (“boîte noire”) ;

- Dépendance à des fournisseurs de modèles ou d’API non maîtrisés ;

- Défauts de robustesse ou d’interopérabilité.

B. Risques éthiques et sociétaux

- Discrimination directe ou indirecte ;

- Atteinte à la vie privée ;

- Manipulation ou mésinformation ;

- Déshumanisation des processus de décision.

C. Risques juridiques et de conformité

- Non-respect du futur AI Act européen ;

- Absence d’évaluation des risques réglementaires ;

- Inadéquation des politiques de gouvernance interne ;

- Responsabilité floue en cas d’erreur algorithmique.

D. Risques organisationnels

- Manque de compétences internes pour encadrer les projets IA ;

- Absence de processus d’audit ou de validation des modèles ;

- Inadéquation entre l’usage de l’IA et la stratégie métier.

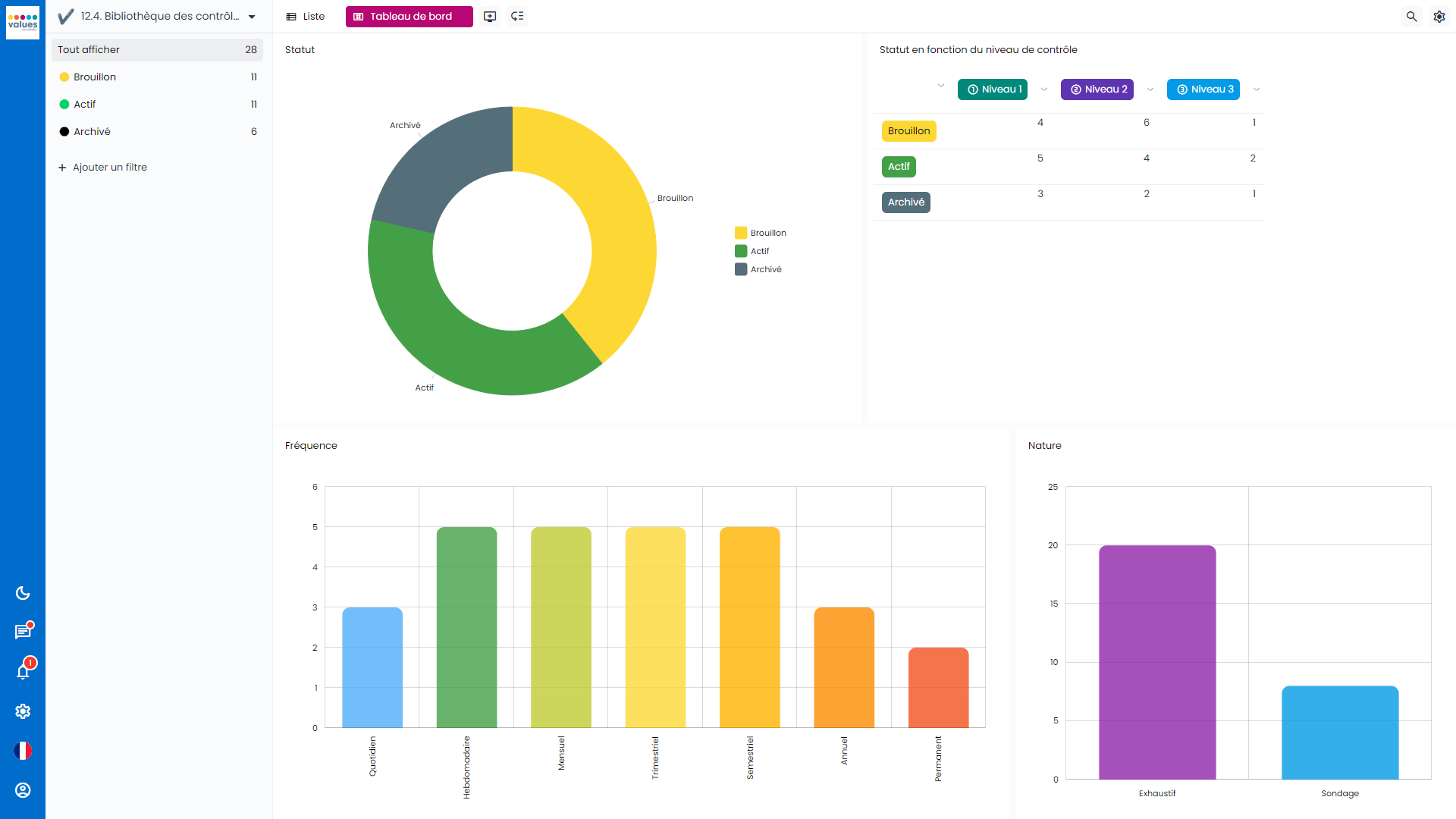

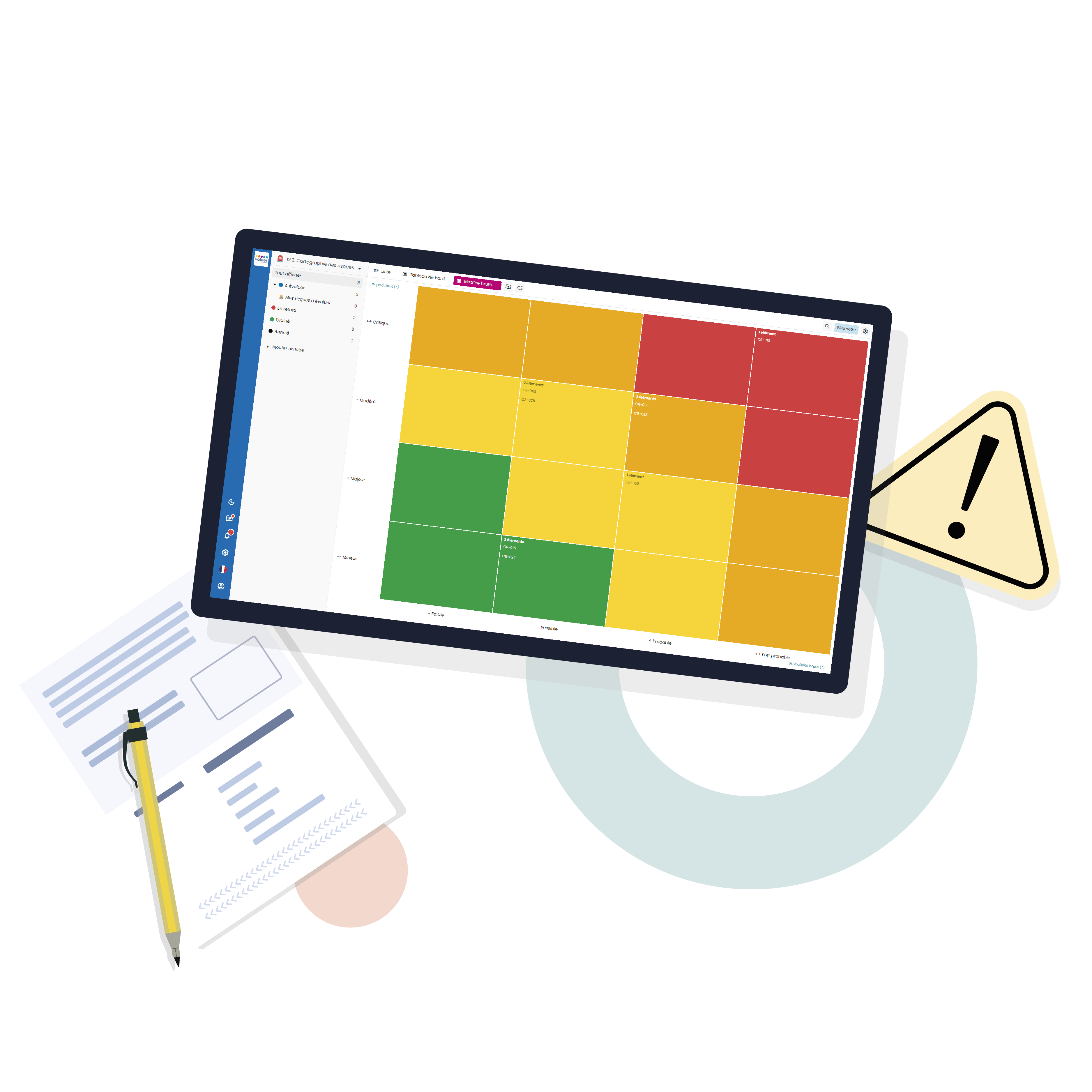

💻 Notre solution pour la gestion des risques liés à l’IA

Le logiciel Values Associates accompagne les organisations dans la gestion des risques liés à l’intelligence artificielle.

➡️ Centraliser les données et évaluer les risques à chaque étape du cycle de vie des projets IA ;

➡️Garantir la conformité avec les cadres réglementaires (AI Act, ISO/IEC 42001, CNIL, OCDE) ;

➡️Renforcer la gouvernance et la traçabilité des modèles au sein de l’organisation.

⚖️ Cadres de référence et réglementation

Les référentiels émergents autour de l’IA visent à assurer un développement sûr et responsable :

- AI Act (Union européenne) : classification des systèmes selon leur niveau de risque ;

- OCDE : Principes sur l’IA responsable ;

- ISO/IEC 42001 : système de management de l’IA ;

- CNIL : Recommandations IA et données personnelles ;

- HLEG (High-Level Expert Group on AI) : lignes directrices pour une IA éthique.

Ces cadres offrent une base pour déployer des solutions d’intelligence artificielle fiables, explicables et conformes.

🛠️ Bonnes pratiques de gestion des risques face à l’Intelligence Artificielle

Pour maîtriser les risques liés à l’intelligence artificielle :

✅ Mettre en place une gouvernance IA claire et documentée ;

✅ Identifier les cas d’usage à haut risque ;

✅ Réaliser des évaluations d’impact éthique et réglementaire ;

✅ Assurer la traçabilité et l’auditabilité des modèles ;

✅ Former les équipes aux enjeux de biais, d’éthique et de conformité.

Vers une IA responsable et durable

Les risques IA dépassent la simple dimension technique : ils touchent à la gouvernance, à l’éthique et à la confiance.

Les anticiper permet de favoriser une innovation responsable et durable, conforme aux valeurs et obligations des organisations.

Le logiciel Values Associates s’inscrit dans cette démarche en offrant une approche globale pour piloter, documenter et sécuriser les projets d’intelligence artificielle.

❓ FAQ – Risques liés à l’intelligence artificielle

Quels sont les principaux risques liés à l’intelligence artificielle ?

Les risques IA couvrent les biais algorithmiques, la perte de contrôle, les atteintes à la vie privée, la désinformation et le non-respect des cadres réglementaires comme le futur AI Act européen.

Pourquoi évaluer les risques d’un système d’IA ?

Une évaluation permet d’anticiper les impacts éthiques, juridiques et organisationnels avant le déploiement et de garantir un usage conforme et responsable de la technologie.

Qu’est-ce que l’AI Act ?

L’AI Act est le futur règlement européen qui classifie les systèmes d’intelligence artificielle selon leur niveau de risque (minimal, limité, élevé, inacceptable) et impose des obligations spécifiques de conformité et de transparence.

Comment assurer la conformité de son IA ?

Les organisations doivent adopter une gouvernance claire, documenter les modèles utilisés, réaliser des audits réguliers et sensibiliser leurs équipes à l’éthique et aux biais.

Comment Values Associates accompagne la gestion des risques IA ?

La solution Values Associates permet d’évaluer les risques à chaque étape du cycle de vie de l’IA, d’assurer la conformité avec les cadres réglementaires et de renforcer la confiance dans les processus automatisés.